Le SEO en 2011. Compte rendu SMX Londres.

Le SMX de Londres a eu lieu du 16 au 17 mai 2011. Vous verrez dans cet article ce qui fonctionne dans le référencement de site, aujourd’hui, en 2011. Il s’agit d’une traduction. Comme je ne suis pas très favorable aux traductions littérales d’articles j’ai traduis cet article à ma manière tout en l’agrémentant de mes propres ressources. Même s’il présente parfois quelques contradictions et banalités je me suis abstenu d’apporter des commentaires. N’hésitez pas à réagir dans les commentaires de l’article si vous le souhaitez. Aller je commence…

***

Le SEO (référencement naturel) a évolué, certes, les choses se présentent différemment en 2011, ce n’est plus comme avant… Face à Google Panda – la « dernière » mise à jour de Google – les webmestres étaient confrontés à des questions. Lors du SMX de Londres 2011 des participants ont donné des réponses.

Dans les années 1990 le SEO (référencement naturel) était relativement facile. Aujourd’hui, les algorithmes des moteurs de recherche sont très complexes et il y a des équipes énormes dédiées à la lutte contre le spam.

Même si des SEO utilisent encore d’anciennes méthodes de référencement, en 2011 les choses se présentent différemment. Les algorithmes extrêmement complexes ont un impact sur les facteurs on-site, off-site et sociaux et ils doivent les tenir en compte.

Mikkel deMib Svendsen (Directeur de la création chez deMib.com), Max Thomas (président/fondateur de l’agence Thunder SEO) et Christine Churchill (présidente de KeyRelevance) ont présenté quelques pistes à suivre en 2011 pour obtenir un référencement efficace.

1. N’optimisez pas pour les moteurs de recherche, optimisez plutôt pour les utilisateurs.

Selon Mikkel l’optimisation du site pour les utilisateurs est la meilleure stratégie SEO à long terme. C’est la tendance que suivront toujours les moteurs de recherche.

Ce que font les SEO n’est pas nécessairement ce que veulent les utilisateurs du Web.

La rétro-ingénierie d’aujourd’hui – ou ingénierie inversée – ne permet d’optimiser un site que selon les algorithmes d’hier.

On peut toutefois admettre quelques exceptions à la règle.

2. Faites preuve de bon sens.

Un taux de rebond élevé peut signifier que le contenu de la page est de faible qualité. Avec Google Panda de nouveaux signaux sont pris en compte. L’engagement social est un des indicateurs importants.

Max Thomas a cité Matt Cutts qui recommandait de supprimer les URLs ou de mettre une balise NOINDEX aux pages de faible qualité. (Lire: En référencement mieux vaut prévenir que guérir)

3. Créer des URLs actives.

Les URLs actives sont des pages qui attirent souvent des visites, des pages qui attirent des liens, des pages partagées dans les réseaux sociaux, des pages que les utilisateurs revisitent. Pour cela il faut se concentrer sur la qualité des contenus.

4. Multipliez les sources.

Le trafic de votre site ne doit pas dépendre uniquement de Google. Un exemple, les campagnes de liens sponsorisés sont une alternative à la recherche organique. L’achat d’espaces commerciaux dans les résultats de recherche de Google expose le client à moins de risques.

Il faut diversifier la source de liens entrants. Pour Christine Churchill il est nécessaire qu’un site se construire un réseau de liens depuis les réseaux sociaux.

5. Diminuer les bannières publicitaires.

Il faut redoubler d’attention sur la qualité de contenu des pages. L’après Google Panda nécessite la réduction de bannières publicitaires.

6. Les classiques fonctionnent toujours.

Penser à optimiser les pages du site pour l’utilisateur, pas uniquement pour les moteurs de recherche.

7. Google Instant change la donne.

Google instant a changé le comportement des googlers. Ils tapent leurs requêtes plus lentement pour voir les résultats que proposent les suggestions de Google. Selon Christine les propriétaires de sites et les webmestres doivent prendre en compte les suggestions de Google pour leur site.

8. Le « long clic ».

Le CTR, le taux de rebond et le temps passé sur le site sont des données qui permettent de mesurer la qualité des pages d’un site. Il faut s’attacher à la création de contenu de qualité.

Google aime lorsqu’un utilisateur passe du temps sur le site qu’il visite. Si l’utilisateur vient sur un site pour repartir aussitôt, le rebond est important, on appelle cela un « clic court », la page est donc comprise comme un contenu de mauvaise qualité.

En conclusion :

Étant donné que les algorithmes de Google sont devenus beaucoup complexes, les SEO et webmestres ne peuvent plus faire l’impasse du contenu de qualité. Ils doivent se poser la question : « Quel contenu créer pour qu’il soit partagé dans les réseaux sociaux et revisité plusieurs fois par la même personne ? Quel contenu créer pour attirer des liens ? (linkbaiting) ». Pour aider le webmestre Google a récemment publié un article sur les questions qu’il doit se poser s’il souhaite créer un site de qualité. (Lien : Le site de qualité selon Google)

Ils doivent multiplier les referrers – référants ou sources de trafic – pour ne pas dépendre de Google. Les médias sociaux – YouTube, Flickr, les blogs, les communiqués, les sites de bookmarking social, etc. – sont devenus incontournables dans une stratégie de référencement de site.

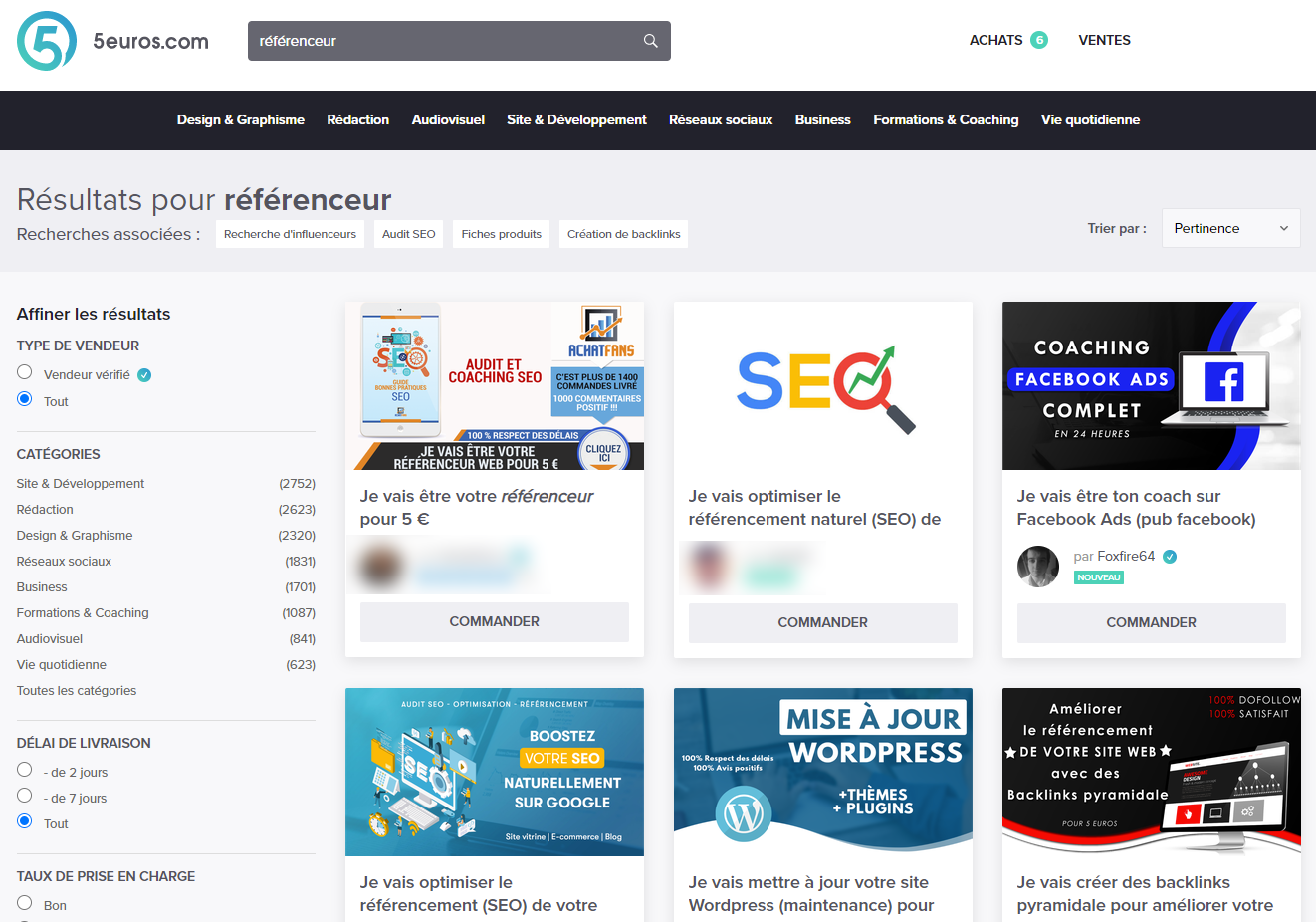

Prestation.

Le référencement de votre site traverse des difficultés ? Vous générez peu de chiffre d’affaire ? Si vous souhaitez être conseillé par un spécialiste du référencement, contactez-moi par e-mail ou sur Twitter.