Google Panda dopera-t-il le marché du référencement ?

Selon Alex Smith, jeune anglais qui travaille à l’agence de relations publiques Punch Communications, la dernière mise à jour de Google nommée « Panda » aurait un impact positif sur le marché du SEO (référencement naturel). Tiens, et pourquoi donc ? Voici les 4 raisons qu’il propose :

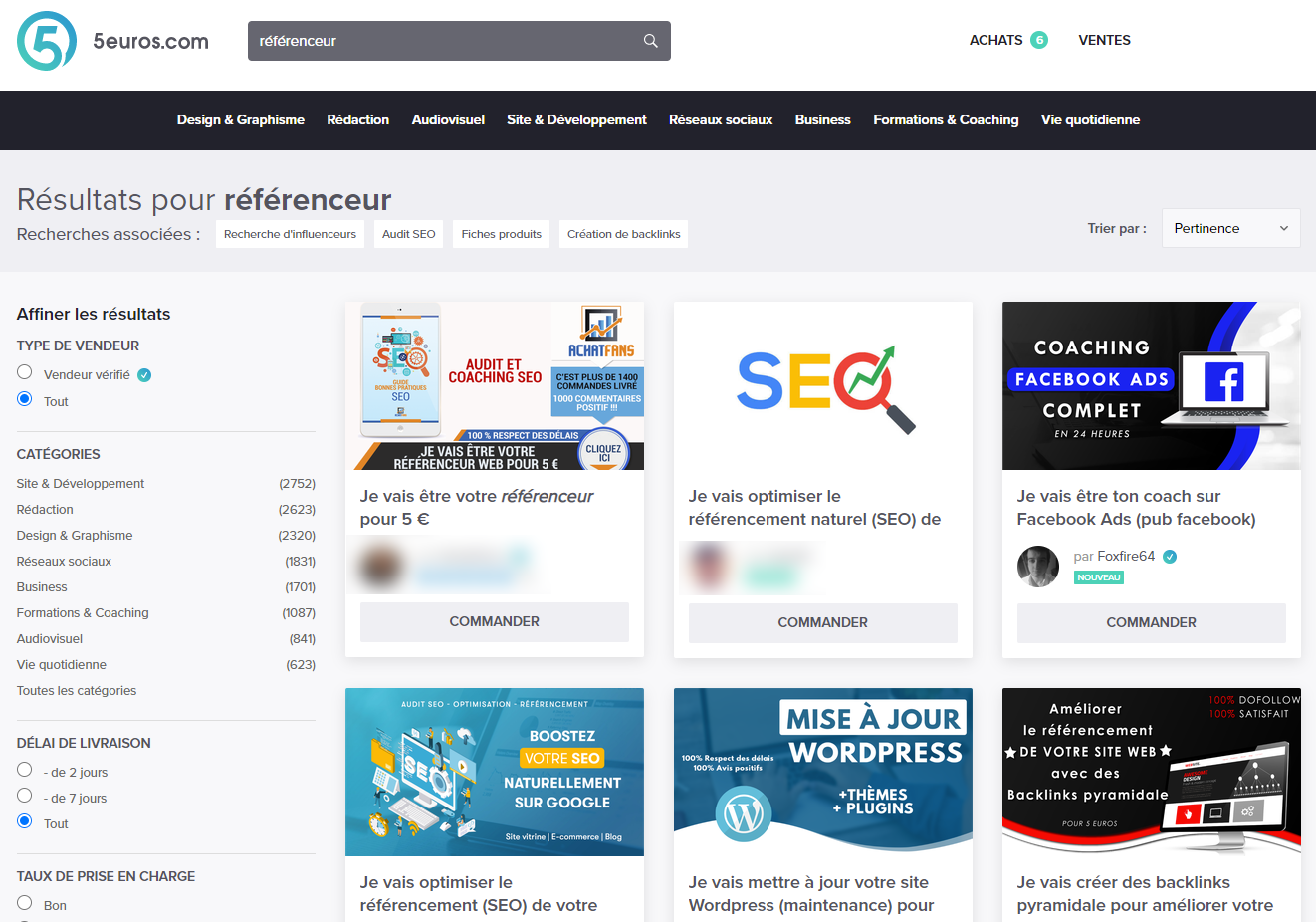

- Panda va accroître la demande en service de référencement. De nombreux spécialistes du marketing numérique qui pensaient que leur stratégie de référencement était parfaite verront probablement leur leurs pages chuter dans le classement de Google. Les consultations de spécialistes en référencement vont donc accroître.

- Les compagnies vont renforcer leur stratégie de référencement de site.

- Moins de spam et de fermes de liens. Ce qui mène au point suivant.

- Un effet dissuasif sur certaines techniques de Black-Hat. La mise à jour Panda a prit des mesures pour assainir l’industrie du SEO et mettra davantage l’accent sur des stratégies éthiques en dévaluant les fermes de liens et les sources de spam web.

Ce que je pense de ces 4 raisons.

Je dirais que si la demande en services de référencement augmentait suite à l’annonce de la dernière mise à jour, c’est parce que les internautes sont mal informés. La mise à jour Google Panda ne concerne, à priori, que les gros sites à fort trafic : portails, comparateurs de prix, plateformes de contenus à la demande (fermes de contenus). Votre site qui contient 5 à 10 pages (site statique / site vitrine), ou votre blog, ne souffrira pas de la mise à jour, peut-être même que les pages de votre site profiteront d’un meilleur classement, mais pour cela il y a des conditions. De plus cette mise à jour concerne en grande partie les sites américains, les sites anglophones de manière générale.

L’auteur semble ne parler que de fermes de liens, or la mise à jour Google Panda est plutôt focalisée sur les fermes de contenus. J’ai bien relu la date de publication de l’article d’Alex, il n’y a pas d’erreur l’article est bien récent…

L’auteur fait souvent allusion au netlinking de qualité. D’après lui les entreprises miseront beaucoup plus sur la recherche de liens de qualité, dit-il. Je crois bien que c’était déjà le cas ou peut-être que votre site est entre les mains de charlatans, vous êtes probablement victime d’une arnaque.

L’auteur oublie de parler du sujet central : le contenu de qualité. Dans son article le terme « contenu » n’est utilisé qu’une fois, mais pas pour parler de sa nature – le bon ou le mauvais contenu. Il faut cesser avec les duplications de contenus, les contenus mal « spinnés », les pages qui contiennent très peu de texte, les pages étouffées de publicités en tous genres (bannières, vidéos, pop-ups, etc.). Alex travaille en agence de relations publiques, pourquoi ne parle-t-il pas de l’expérience utilisateur ? Il est mieux placé pour en parler. Sur le blog de communication Web je propose quelques critiques de « communiqués » que les auteurs publient sur la plateforme Communique-de-presse.info. J’ai l’intention de parler d’une agence de référencement – bien réputée en région parisienne, je tiens à le dire – qui pratique le Duplicate Content sans le moindre scrupule. Le cas n’est pas isolé.

La 4ème raison est que Google Panda aurait pour effet de dissuader les techniques Black-Hat. Cela va dépendre des techniques de netlinking et de création de contenu exploitées par les sites. Rand Fishkin – l’étiqueté White-Hat – utilise des techniques Black-Hat dans une perspective White-Hat. La frontière entre le White et le Black-Hat est floue.

Il faut savoir que chaque mois les algorithmes de Google évoluent, la plupart des évolutions sont invisibles et font leur « travail d’assainissement » quotidien des résultats de recherche. J’émets toutefois quelques réserves sur l’aspect qualitatif des résultats de recherche, mais ceci est un autre débat. Il faut faire preuve de vigilance en permanence quelles que soient les mises à jour, c’est ce qu’il faut retenir.

Vous avez des questions sur Google Panda ? Venez m’en parler sur Twitter ou directement via ma page de contact.

L’article d’Alex Smith :

- 4 reasons Google’s Panda update is positive for the SEO industry (SocialMediaToday.com)

NJ

5 mai 2011 15 h 19 minOui cela va booster le referencement mais les annonceurs seraient bien avisés de changer d’agence !

Une petite apparté sur “comment survivre à Panda” : Il existe une solution simple dont personne ne parle et pour cause, les referenceurs sont trop attachés à suivre à la lettre ce que dit le Dieu Google, c’est justement de ne pas être Googlisé.

Concrêtement : arrêtez d’utiliser google analytics par exemple. Arrêtez d’utiliser google webmater tools car tous ces outils fournissent des données importantes à Google pour juger de votre site comme le taux de rebond, la durée de passage sur le site, la part de google sur votre audience etc…Ces données vont servir en partie à Google pour vous déclasser ou non.

Mais pour ceux qui n’utilisent pas ces outils google, sont ils pour autant pris en compte dans le referencement ? Bien sur et moins Google en sait sur vous, plus vous avez de chances de bien figurer par le seul contenu de votre site !

J’ai une dizaine de sites web. La moitie n’utilise pas les outils google. Ca ne les empeche pas d’être dans le Top 5 ou Top 10 dans google, d’avoir un page rank élevé !

Alors, un bon conseil, dégoogleisez vous, ca peut être un mal pour un bien. En tous les cas, pour moi ca fonctionne très bien.

PS : TOUS LES SITES SONT CONCERNES PAR PANDA, PETITS OU GRANDS. Il suffit de lire les commentaires de webmastaires américains sur le forum de google pour se rendre compte que même les petits et irréprochables petits sites ont subi l’ouragan Panda.

Celui qui a peur

6 mai 2011 8 h 47 minJ’ai peur de Panda… J’ai peur qu’il ne vienne grignoter les positions de mes sites. Je vais me reconvertir comme berger, ou quelque chose de plus tranquille que consultant en référencement !