L’utilité du fichier robots.txt

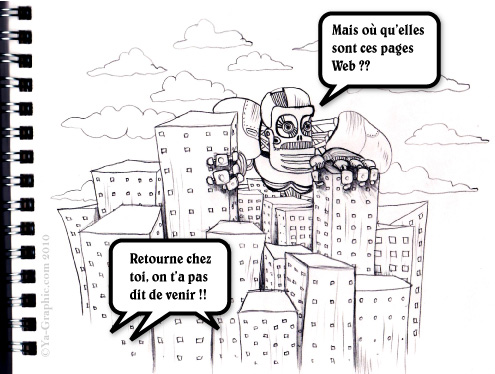

Les robots de moteurs de recherche (appelés aussi spiders ou crawlers) sont des programmes qui explorent en permanence les pages Web du monde. Les moteurs de recherche (Google, Bing et Yahoo!) les exploitent pour indexer de nouvelles pages Web.

Bloquer ou supprimer des pages à l’aide d’un fichier robots.txt

Il est possible de s’adresser à ces robots, non pas pour faire connaissance autour d’un café mais pour leur indiquer de ne pas accéder à des pages Web de votre site/blog. Il existe bien sûr d’autres moyens pour ne pas leur autoriser l’accès : fichier .htaccess, balise Meta noindex. Toutefois, tous les robots n’interprètent pas de la même manière ce que vous leur indiquez.

Vous avez indiqué aux robots de ne pas indexer des pages de votre site/blog ? Cette interdiction ne garantit rien parce que les moteurs de recherche peuvent indexer les URL de vos pages s’ils les rencontrent sur d’autres sites Web. Autrement dit, vos pages Web peuvent apparaître dans les résultats de recherche même si vous n’avez pas autorisé les robots de les explorer.

Pour créer et installer un fichier robots.txt, il faut créer un fichier texte, le nommer robots.txt (attention au pluriel) et le placer à la racine de votre site Web. Vous souhaitez inclure des informations dans le fichier robots.txt ? Vous trouverez plus d’informations au Centre d’aide Outils pour les Webmasters (Google).

L’envoi de fichiers sitemap (xml) via le fichier robots.txt

Le fichier robots.txt a une autre vertu. Il peut indiquer aux robots l’emplacement de votre sitemap. Vous devriez l’indiquer. Il suffit simplement d’ajouter cette ligne dans le fichier robots.txt :

- Sitemap:

Si votre site comporte plus de 50 000 URL, vous pouvez créer plusieurs sitemap qui se partageront chacune 50 000 URL au maximum. Vous pouvez spécifier plus d’un fichier sitemap par fichier robots.txt :

- Sitemap:

- Sitemap:

Il existe bien sûr d’autres moyens pour indiquer aux moteurs de recherche l’emplacement de votre sitemap : la soumission directe dans les moteurs de recherche (outils pour les webmasters), les requêtes HTTP (ping).

Tester son fichier robots.txt par Google

Pour tester la validité de son fichier robots.txt il suffit d’utiliser l’outil de Google dans les outils pour les webmasters (Google Webmaster Tools). Ce test ne concernera que les user-agents de Google (les robots de Google, Googlebot).

Quelques exemples de fichiers robots.txt

Allez sur Google, tapez ce code : inurl:robots.txt filetype:txt

Vous trouverez le fichier robots.txt de Google, de Wikipédia, Webmasterworld, la Maison Blanche, de Microsoft, de W3.org, de Facebook, d’IBM, Amazon, Ebay, du New York Times, de la CNN, de YouTube, etc.

gael

27 février 2010 14 h 32 minEt dire que je connais une “agence” web-marketing qui ne plaçait même pas de robots.txt pour le référencement d’un site e-commerce de client…

Épicentre-Référencement

18 juillet 2010 18 h 32 minPersonnellement je me sers toujours du fichier robots.txt mais pour interdire certaine page aux moteurs.

Mais je ne connaissais pas cette astuce pour leurs indiquer le fichier sitemap.

Merci pour l’astuce.